#78 DeepSeek R-1: Como a IA Chinesa Aberta Está Desafiando Gigantes do Vale do Silício: Radar IA

Prompt da Semana: Universal para Modelos de Raciocínio, Radar IA Tutoriais: Receba Resumos Diários de Notícias Globais com ChatGPT, Papers da semana e mais.

Radar IA

O Radar IA é uma publicação semanal exclusiva dos assinantes premium. Aqui você descobre como aumentar sua produtividade e rentabilizar mais seu negócio com ferramentas de IA, Tutoriais, Prompts e mais. Se você ainda não é premium e quer ter acesso essas oportunidades: CLIQUE AQUI E ASSINE AGORA.

O que temos para hoje:

DeepSeek R-1: Como a IA Chinesa Aberta Está Desafiando Gigantes do Vale do Silício

O que está no nosso Radar

Papers da Semana:

DeepSeek-R1: A Revolução Chinesa na Inteligência Artificial

Modelos de Linguagem Colaboram para Tarefas de Longo Contexto

Prompt da semana: Planeje Fins de Semana Perfeitos com ChatGPT!

Crie Ilustrações Personalizadas para Sua Marca com Freepik AI

Ferramentas de IA da semana

DeepSeek R-1: Como a IA Chinesa Aberta Está Desafiando Gigantes do Vale do Silício

Os mercados globais foram abalados recentemente.

A cena de Inteligência Artificial (IA) global viu um avanço inesperado (mas que já vinha acontecendo a mais de ano) quando a DeepSeek, uma startup chinesa relativamente desconhecida até pouco tempo, revelou seu primeiro modelo de raciocínio, o R-1. A iniciativa chamou muita atenção por aplicar uma técnica de cadeia de pensamento parecida com o modelo o1, da OpenAI, possibilando que a IA contornasse desafios complexos de lógica e matemática.

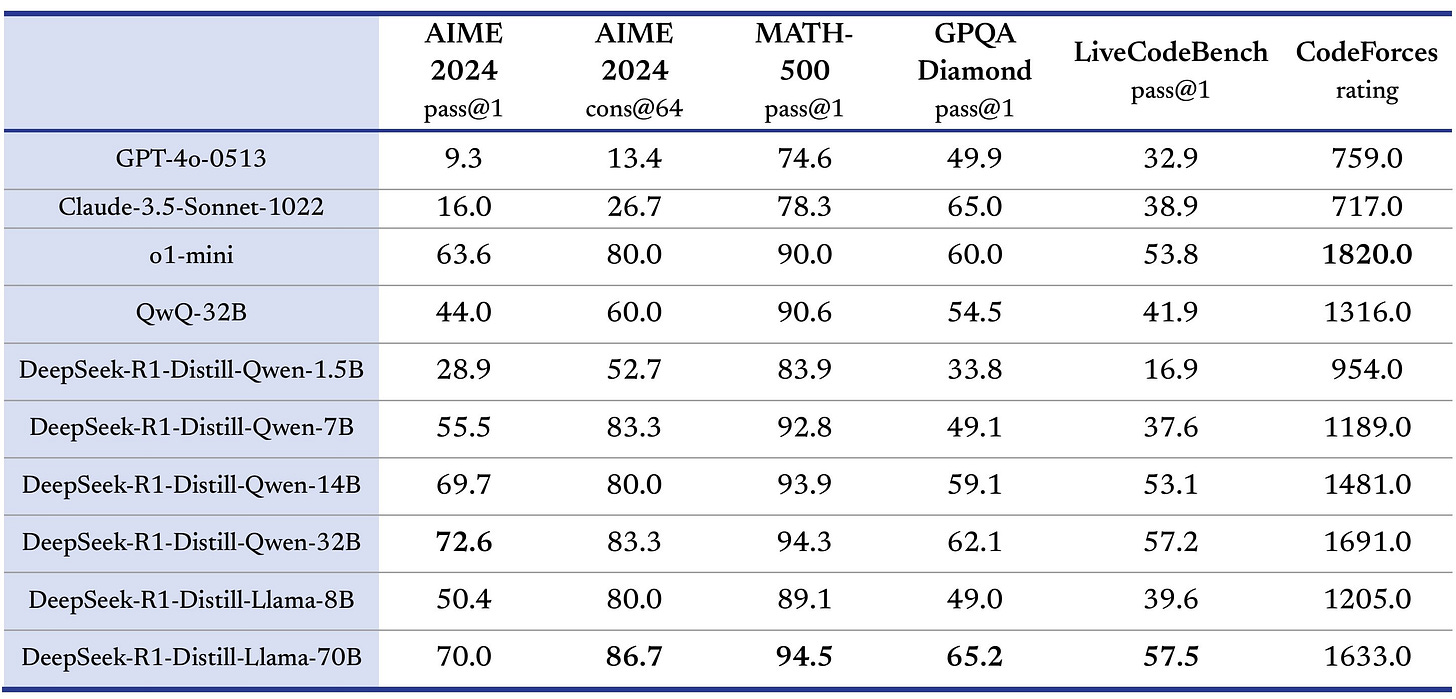

Ao analisar diferentes benchmarks, pesquisadores notaram que o R-1 não apenas emparelha com o modelo o1, fechado e mantido pela OpenAI, mas inclusive supera outros competidores em determinadas questões. Esse desenvolvimento sugere que a DeepSeek, embora tenha surgido sem muito barulho, acabou se tornando um centro de inovação para aplicativos avançados de IA.

Com sede na China, a empresa utilizou seu modelo v3 como base e, logo em seguida, adicionou camadas de aprendizado por reforço para obter o R-1, que se destaca por respostas muito mais coerentes e precisas. Além disso, o R-1, por ser Open Source (de código aberto) contrasta bastante com a política de segredo corporativo tipicamente adotada no Ocidente. Enquanto a OpenAI, o Google e a Anthropic têm mantido sigilo sobre vários aspectos de seus modelos e tecnologias, a DeepSeek publicou relatórios detalhados e distribuiu suas criações, gerando um frisson e um novo patamar de transparência e colaboração no setor.

Em paralelo, o R-1 não surgiu do zero, mas evoluiu a partir de uma base já bastante robusta, batizada de DeepSeek v3. Engenheiros desafiaram essa base em problemas complexos de lógica e matemática, adotando um método de “reforço puro” para estimular o modelo a desenvolver raciocínios mais profundos sem depender massivamente de anotações humanas passo a passo. A ideia lembra o marco histórico da DeepMind com o AlphaGo Zero, quando uma IA conseguiu ultrapassar seu antecessor ao treinar sem recorrer a lances já realizados por jogadores experientes.

Embora a comparação entre Go e linguagens humanas seja mais complexa, o R-1 Zero chama atenção por suas habilidades emergentes de raciocínio, mesmo que apresente alguns pontos menos polidos. Segundo a DeepSeek, o R-1 Zero mostra que o aprendizado por reforço puro ainda tem potencial em modelos de linguagem natural, sobretudo quando combinado a técnicas adicionais que visam melhorar a interpretação dos raciocínios internos e alinhar o comportamento do sistema às preferências do usuário e às diretrizes de segurança. Na prática, esse processo resultou em duas variantes: o R-1 Zero, focado puramente em autorreflexão, e o R-1, que incorpora um mínimo de exemplos supervisionados, além de etapas de ajuste fino para torná-lo mais legível e compatível com expectativas humanas.

Outro ponto importante apresentado pela DeepSeek é a capacidade do R-1 de funcionar como um “modelo treinador” para redes menores, o que é algo bastante importante e falei sobre isso em nossa última edição, da possibilidade do GPT5 já existir, mas seguir treinando modelos menores internamente na OpenAI:

Isso ocorre graças a um mecanismo chamado “distillação,” em que o conhecimento do sistema principal é transferido para outro modelo com menos parâmetros, otimizando recursos de hardware e reduzindo a barreira de entrada para quem deseja aplicar IA avançada sem dispor de supercomputadores ou chips de última geração.

Nesse contexto, a DeepSeek divulgou seis modelos menores, incluindo variações baseadas em Qwen e Llama, que se beneficiaram desse método de distillação.

Os resultados divulgados indicaram ganhos expressivos em tarefas de raciocínio, codificação e até questões matemáticas, aproximando essas versões compactas do nível de modelos mais robustos no mercado.

Enquanto a OpenAI faz anúncios sobre atualizações como o o3 ou versões subsequentes, a DeepSeek segue desbravando opções open source a custos bastante reduzidos. Esse movimento expõe uma dinâmica bastante interessante: a startup chinesa não apenas compete em termos de desempenho, mas também lança mão de estratégias agressivas de abertura que podem mudar o panorama global de desenvolvimento de IA, e por isso o grande frisson e derrubada agressiva do mercado.

Com custos entre 5% a 10% do que a OpenAI teria desembolsado no treinamento do modelo o1, a DeepSeek instiga perguntas sobre sustentabilidade econômica, modelos de negócio e até sobre possíveis incentivos governamentais.